Ollama 部署使用笔记

Ollama 部署使用笔记

01 Ollama介绍

1.1 基本介绍

Ollama是一个支持在Windows、Linux和MacOS上本地运行大语言模型的工具。它允许用户非常方便地运行和使用各种大语言模型,比如Qwen模型等。用户只需一行命令就可以启动模型。

主要特点包括:

- 跨平台支持Windows、Linux、MacOS系统。

- 提供了丰富的模型库,包括Qwen、Llama等1700+大语言模型,可以在官网model library中直接下载使用。

- 支持用户上传自己的模型。用户可以将huggingface等地方的ggml格式模型导入到ollama中使用。也可以将基于pytorch等格式的模型转换为ggml格式后导入。

- 允许用户通过编写modelfile配置文件来自定义模型的推理参数,如temperature、top_p等,从而调节模型生成效果。

- 支持多GPU并行推理加速。在多卡环境下,可以设置环境变量来指定特定GPU。

- 强大的技术团队支持,很多模型开源不到24小时就能获得支持。

- 总的来说,Ollama降低了普通开发者使用大语言模型的门槛,使得本地部署体验大模型变得简单易行。对于想要搭建自己的AI应用,或者针对特定任务调优模型的开发者来说,是一个非常有用的工具。它的一些特性,如允许用户自定义模型参数,对模型进行个性化适配提供了支持。

- Ollama 服务器端口为11434,如dify等大模型应用平台对接此端口进行调用模型。

1.2 官网

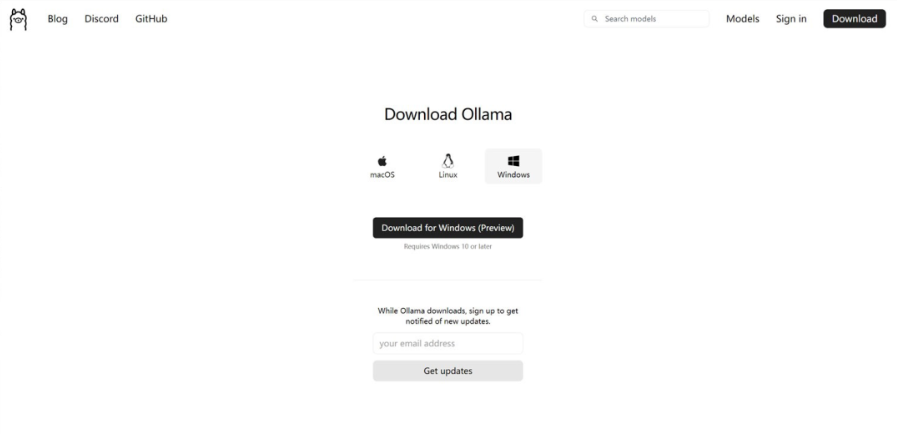

- Ollama 下载:https://ollama.com/download

- Ollama 官方主页:https://ollama.com

- Ollama 官方 GitHub 源代码仓库:https://github.com/ollama/ollama/

02 安装

2.1 在Windows 安装,指定路径

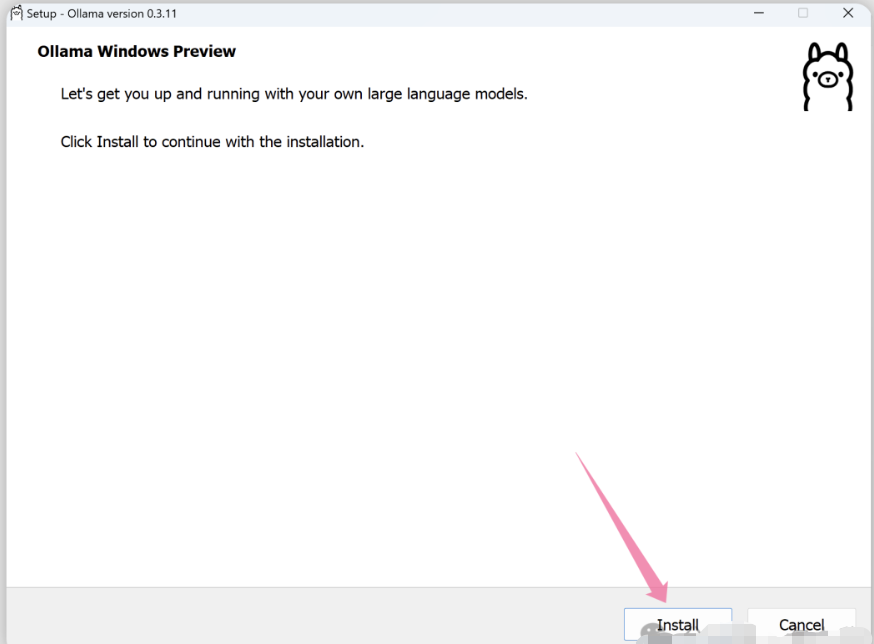

本地部署大模型的方法很多,这里介绍一种——使用Ollama。首先,Ollama的安装是比较简单的,只需要从官网(Download Ollama on Windows)下载安装包,之后一键install即可。但这样做有个问题,就是会默认安装到C盘(后续下载的大模型文件也会存到C盘)。本文会介绍如何指定安装路径(比如安装到D盘),并从Ollama官网下载和运行DeepSeek。

直接从下载页面下载相对应系统的安装程序,Windows安装程序选择Windows的安装包,点击“Download for Windows(Preview)”

在OllamaSetup.exe安装程序保存目录中,鼠标右键打开终端

输入”OllamaSetup.exe /DIR=F:\Ollama\Apps”,然后回车,进入到安装界面后,点击Install按钮即可。

安装完成之后,打开一个cmd命令窗口,输入ollama命令,如果显示ollama相关的信息就证明安装已经成功了!

2.2 在Mac 安装

直接从下载页面下载相对应系统的安装程序,Windows安装程序选择Windows的安装包,点击“Download for Mac”

下载好后打开安装命令行

2.3 在Linux安装

在Linux系统上,可以通过脚本安装或源码编译的方式来安装Ollama。下面分别介绍这两种安装方法。

2.3.1 脚本安装

Ollama提供了一键安装脚本,可以快速在Linux系统上安装Ollama。安装步骤如下:

打开终端,执行以下命令下载安装脚本:

1

curl -fsSL https://ollama.com/install.sh | sh等待安装完成。安装脚本会自动下载所需的组件,并完成

Ollama的安装与配置。安装完成后,可以通过以下命令启动

Ollama:1

2systemctl start ollama.service # 启动ollama服务

systemctl status ollama.service # 查看ollama服务状态

Tips:使用install.sh安装ollama时,脚本中使用的是curl命令进行下载。如果网络不好的情况下,下载需要需要很长时间。可以修改install.sh脚本,在所有的curl命令行中添加-x参数使用代理进行下载。

1 | |

2.3.2 二进制安装

将 Ollama 的二进制文件下载到 PATH 中的目录:

1

2sudo curl -L https://ollama.com/download/ollama-linux-amd64 -o /usr/bin/ollama

sudo chmod +x /usr/bin/ollama将 Ollama 添加为自启动服务,首先,为 Ollama 创建用户:

1

sudo useradd -r -s /bin/false -m -d /usr/share/ollama ollama然后在该位置:

/etc/systemd/system/ollama.service 创建服务文件1

2

3

4

5

6

7

8

9

10

11

12

13[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

[Install]

WantedBy=default.target设置开机自启动

1

2sudo systemctl daemon-reload

sudo systemctl enable ollama启动 Ollama,使用以下命令启动 Ollama:

1

sudo systemctl start ollama

2.4 安装特定版本

设置 OLLAMA_VERSION字段,,可以安装对应的版本

1

curl -fsSL https://ollama.com/install.sh | OLLAMA_VERSION=0.3.13 sh1

2.5 查看Ollama日志

查看作为启动服务运行的 Ollama 的日志:

1 | |

2.6 更新Ollama

1 | |

2.7 卸载Ollama

停止和删除Ollama 服务:

1

2

3sudo systemctl stop ollama

sudo systemctl disable ollama

sudo rm /etc/systemd/system/ollama.service从 bin 目录中删除 Ollama 二进制文件:/usr/local/bin ,/usr/bin ,/bin

1

sudo rm $(which ollama)删除下载的模型和 Ollama 服务用户和组:

1

2

3sudo rm -r /usr/share/ollama

sudo userdel ollama

sudo groupdel ollama

03 命令参数

以下是 Ollama 使用常见的指令:

1 | |

3.1 使用例子

运行deepseek-r1:7b模型

1

2

3

4

5

6root@TM1701:~# ollama run deepseek-r1:7b

>>> 你是谁?

<think>

</think>

您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。如您有任何任何问题,我会尽我所能为您提供帮助。

>>> Send a message (/? for help)查看ollama已安装的模型

1

2

3

4root@TM1701:~# ollama list

NAME ID SIZE MODIFIED

deepseek-r1:7b 0a8c26691023 4.7 GB 23 hours ago

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 23 hours ago删除ollama已安装的模型

1

root@TM1701:~# ollama rm deepseek-r1:1.5b

04 设置自定义模型下载路径

默认情况下,ollama模型的存储目录如下:

1 | |

4.1 Windows 更改 Ollama 模型存放位置

在Windows系统中,若要更改Ollama模型的存放位置,可以按照以下步骤操作:

打开环境变量编辑界面。可以通过以下方式:

- 右键点击“此电脑”或“我的电脑”,选择“属性”。

- 在系统窗口中选择“高级系统设置”。

- 在系统属性窗口中点击“环境变量”按钮。

在环境变量窗口中,点击“新建”创建一个新的系统变量或用户变量。

- 变量名:OLLAMA_MODELS

- 变量值:输入你希望设置的新模型存放路径,例如:D:\Ollama\Models

点击“确定”保存设置。

重启任何已经打开的Ollama相关应用程序,以便新的路径生效。

4.2 Linux/Mac 更改 Ollama 模型存放位置

在Linux或Mac系统中,更改Ollama模型存放位置的步骤如下:

打开终端。

创建一个新的目录作为模型存放位置,例如:

1

mkdir -p /path/to/your/new/ollama/models设置环境变量。在Linux系统中,可以通过编辑~/.bashrc或~/.bash_profile文件(对于bash shell)或~/.zshrc文件(对于zsh shell)。在Mac系统中,可以通过编辑~/.bash_profile或~/.zshrc文件。使用以下命令编辑文件:

1

2

3

4

5

6

7nano ~/.bashrc

# 或者使用其他的文本编辑器,如vim

在文件末尾添加以下行来设置OLLAMA_MODELS环境变量:

export OLLAMA_MODELS="/path/to/your/new/ollama/models"

# 保存并关闭文件。如果你使用的是nano编辑器,可以按Ctrl + X,然后按Y确认保存,最后按Enter键。使环境变量生效。在终端中运行以下命令:

1

2source ~/.bashrc

# 或者source ~/.bash_profile,取决于你编辑的文件<br/>重启任何已经打开的Ollama相关应用程序,以便新的路径生效。

05 ollama无法使用本地IP访问11434端口,但是localhost和127.0.0.1可以访问

修改ollama配置使其可以监听0.0.0.0和修改端口,可以外网访问

修改文件/etc/systemd/system/ollama.service配置文件,添加如下内容

1

Environment="OLLAMA_HOST=0.0.0.0:11434"修改后的配置文件内容:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/local/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=/root/.local/bin:/root/.pyenv/plugins/pyenv-virtualenv/shims:/root/.pyenv/shims:~/.pyenv/bin:/root/.vscode-server/cli/servers/Stable-e54c774e0add60467559eb0d1e229c6452cf8447/server/bin/remote-cli:/root/.local/bin:/root/.pyenv/plugins/pyenv-virtualenv/shims:~/.pyenv/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin"

Environment="OLLAMA_HOST=0.0.0.0:11434" # 访问范围

Environment="OLLAMA_MODELS=/usr/share/ollama/.ollama/models" # 模型保存路径

[Install]

WantedBy=default.target重启ollama服务

1

2

3sudo systemctl daemon-reload

sudo systemctl restart ollama

sudo systemctl status ollama查看端口信息

1

2

3

4

5# 修改前

tcp 0 0 127.0.0.1:11434 0.0.0.0:* LISTEN 3807239/ollama

# 修改后

tcp6 0 0 :::11434 :::* LISTEN 3811826/ollama